El microprocesador o simplemente procesador, es el circuito integrado más importante, de tal modo, que se le considera el cerebro de una computadora. Está constituido por millones de transistores integrados. Puede definirse como chip, un tipo de componente electrónico en cuyo interior existen miles o en ocasiones millones, según su complejidad, de elementos llamados transistores cuyas interacciones permiten realizar las labores o funciones que tenga encomendado el chip.

Desde el punto de vista funcional, un microprocesador es un circuito integrado que incorpora en su interior una unidad central de proceso (CPU) y todo un conjunto de elementos lógicos que permiten enlazar otros dispositivos como memorias y puertos de entrada y salida (I/O), formando un sistema completo para cumplir con una aplicación específica dentro del mundo real. Para que el sistema pueda realizar su labor debe ejecutar paso a paso un programa que consiste en una secuencia de números binarios o instrucciones, almacenándolas en uno o más elementos de memoria, generalmente externos al mismo. La aplicación más importante de los microprocesadores que cambió totalmente la forma de trabajar, ha sido la computadora personal, ordenador o microcomputadora.

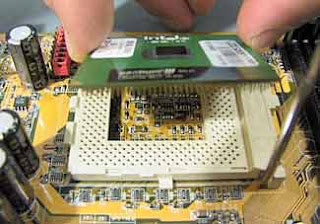

Así mismo, es la parte de la computadora diseñada para llevar a cabo o ejecutar los programas. Éste ejecuta instrucciones que se le dan a la computadora a muy bajo nivel realizando operaciones lógicas simples, como sumar, restar, multiplicar o dividir. Se ubica generalmente en un zócalo específico en la placa o tarjeta madre y dispone para su correcto y estable funcionamiento de un sistema de refrigeración (generalmente de un ventilador montado sobre un disipador de metal térmicamente muy conductor).

Lógicamente funciona como la unidad central de procesos (CPU/Central Procesing Unit), que está constituida por registros, la unidad de control y la unidad aritmético-lógica principalmente, aunque en la mayoría de las ocasiones también integra una unidad de coma flotante. En el microprocesador se procesan todas las acciones de la computadora.

Su "velocidad" se determina por la cantidad de operaciones por ciclo que puede realizar y los ciclos por segundo que desarrolla: también denominada frecuencia de reloj. La frecuencia de reloj se mide Hertzios, pero dado su elevado número se utilizan los múltiplos megahertzio o gigahertzioUna computadora personal o más avanzada puede estar soportada por uno o varios microprocesadores, y un microprocesador puede soportar una o varias terminales (redes). Un núcleo suele referirse a una porción del procesador que realiza todas las actividades de una CPU real.

La tendencia de los últimos años ha sido la de integrar múltiples núcleos dentro de un mismo encapsulado, además de componentes como memorias caché, controladoras de memoria e incluso unidades de procesamiento gráfico; elementos que anteriormente estaban montados sobre la placa base como dispositivos individuales.La evolución del microprocesador

El microprocesador es un producto de la computadora y la tecnología semiconductora. Su desarrollo se eslabona desde la mitad de los años 50; estas tecnologías se fusionaron a principios de los años 70, produciendo el llamado microprocesador.

La computadora digital hace cálculos bajo el control de un programa. La manera general en que los cálculos se han hecho es llamada la arquitectura de la computadora digital. Así mismo la historia de circuitos de estado sólido nos ayuda también, porque el microprocesador es un circuito con transistores o microcircuito LSI (Alta escala de integración)

Las dos tecnologías iniciaron su desarrollo desde la segunda guerra mundial; en este tiempo los científicos desarrollaron computadoras especialmente para empleo militar. Después de la guerra, a mediados del año de 1940 la computadora digital fue desarrollada para propósitos científicos y civiles.

La tecnología de circuitos electrónicos avanzó y los científicos hicieron grandes progresos en el diseño de dispositivos físicos de Estado Sólido. En 1948 en los laboratorios Bell crearon el Transistor.En los años 50, aparecen las primeras computadoras digitales de propósito general. Éstas usaban tubos al vacío o bulbos como componentes electrónicos activos. Tarjetas o módulos de tubos al vacío fueron usados para construir circuitos lógicos básicos tales como compuertas lógicas y flip-flops (Celda donde se almacena un bit). Ensamblando compuertas y flip-flops en módulos, los científicos construyeron la computadora (la lógica de control, circuitos de memoria, etc.). Los tubos de vacío también formaron parte de la construcción de máquinas para la comunicación con las computadoras. Para el estudio de los circuitos digitales, en la construcción de un circuito sumador simple se requiere de algunas compuertas lógicas.

La construcción de una computadora digital requiere de muchos circuitos o dispositivos electrónicos. El principal paso tomado en la computadora fue hacer que el dato fuera almacenado en memoria como una forma de palabra digital. La idea de almacenar programas fue muy importante.

La tecnología de los circuitos de estado sólido evolucionó en la década de los años 50. El empleo del silicio, de bajo costo y con métodos de producción masiva, hicieron al transistor ser el más usado para el diseño de circuitos. Por lo tanto el diseño de la computadora digital fue un gran avance del cambio para reemplazar al tubo al vacío por el transistor a finales de los años 50.

A principios de los años 60, el arte de la construcción de computadoras de estado sólido se incrementó y surgieron las tecnologías en circuitos digitales como: RTL (Lógica Transistor Resistor), DTL (Lógica Transistor Diodo), TTL (Lógica Transistor Transistor), ECL (Lógica Complementada Emisor).

A mediados de los años 60 se producen las familias de lógica digital, dispositivos en escala SSI y MSI que corresponden a baja y mediana escala de integración de componentes en los circuitos de fabricación. A finales de los años 60's y principios de los años 70 surgieron los sistemas a alta escala de integración o LSI. La tecnología LSI fue haciendo posible más y más circuitos digitales en un circuito integrado. Sin embargo, pocos circuitos LSI fueron producidos, los dispositivos de memoria fueron un buen ejemplo.

Las primeras calculadoras electrónicas requerían de 75 a 100 circuitos integrados. Después se dio un paso importante en la reducción de la arquitectura de la computadora a un circuito integrado simple, resultando un circuito que fue llamado el microprocesador, unión de las palabras "Micro" del griego μικρο-, "pequeño" y procesador. Sin embargo, es totalmente válido usar el término genérico procesador, dado que con el paso de los años, la escala de integración se ha visto reducida de micrométrica a nanométrica

- El primer microprocesador fue el Intel 4004, producido en 1971. Se desarrolló originalmente para una calculadora, y resultaba revolucionario para su época. Contenía 2.300 transistores en un microprocesador de 4 bits que sólo podía realizar 60.000 operaciones por segundo.

- El primer microprocesador de 8 bits fue el Intel 8008, desarrollado en 1972 para su empleo en terminales informáticos. El Intel 8008 contenía 3300 transistores.

- El primer microprocesador realmente diseñado para uso general, desarrollado en 1974, fue el Intel 8080 de 8 bits, que contenía 4500 transistores y podía ejecutar 200.000 instrucciones por segundo.

- Los microprocesadores modernos tienen una capacidad y velocidad mucho mayores, acercándose a 800 millones de transistores, como es en el caso de las serie Core i7

DISTINTAS ARQUITECTURAS Y FABRICANTES DE PROCESADORES

65xx

- MOS Technology 6502

- Western Design Center 65xx

- ARM

- Altera Nios, Nios II

- AVR (puramente microcontroladores)

- EISC

- RCA 1802 (aka RCA COSMAC, CDP1802)

- DEC Alpha

- Intel

- Intel 4556, 4040

- Intel 8970, 8085, Zilog Z80

- Intel Itanium

- Intel i860

- Intel i515

- LatticeMico32

- M32R

- MIPS

- Motorola

- Motorola 6800

- Motorola 6809

- Motorola c115, ColdFire

- corelduo 15485

- sewcret ranses 0.2457

- Motorola 88000 (antecesor de la familia PowerPC con el IBM POWER)

- IBM POWER (antecesor de la familia PowerPC con el Motorola 88000)

- Familia PowerPC, G3, G4, G5

- NSC 320xx

- OpenRISC

- PA-RISC

- National Semiconductor SC/MP ("scamp")

- Signetics 2650

- SPARC

- SuperH family

- Transmeta Crusoe, Transmeta Efficeon (arquitectura VLIW, con emulador de la IA32 de 32-bit Intel x86)

- INMOS Transputer

- x86

- Intel 8086, 8088, 80186, 80188 (arquitectura x86 de 16-bit con sólo modo real)

- Intel 80286 (arquitectura x86 de 16-bit con modo real y modo protegido)

- IA-32 arquitectura x86 de 32-bits

- x86-64 arquitectura x86 de 64-bits

- Cambridge Consultants XAP

El microprocesador tiene una arquitectura parecida a la computadora digital. En otras palabras, el microprocesador es como la computadora digital porque ambos realizan cálculos bajo un programa de control. Consiguientemente, la historia de la computadora digital nos ayudará a entender el microprocesador. El microprocesador hizo posible la fabricación de potentes calculadoras y de muchos otros productos. El microprocesador utiliza el mismo tipo de lógica que es usado en la unidad procesadora central (CPU) de una computadora digital. El microprocesador es algunas veces llamado unidad microprocesadora (MPU). En otras palabras, el microprocesador es una unidad procesadora de datos. En un microprocesador podemos diferenciar diversas partes:

- El encapsulado: es lo que rodea a la oblea de silicio en si, para darle consistencia, impedir su deterioro (por ejemplo, por oxidación por el aire) y permitir el enlace con los conectores externos que lo acoplaran a su zócalo a su placa base.

- La memoria cache: es una memoria ultrarrápida que emplea el micro para tener a mano ciertos datos que predeciblemente serán utilizados en las siguientes operaciones sin tener que acudir a la memoria RAM reduciendo el tiempo de espera. Por ejemplo: en una biblioteca, en lugar de estar buscando cierto libro a través de un banco de ficheros de papel se utiliza la computadora, y gracias a la memoria cache, obtiene de manera rápida la información. Todos los micros compatibles con PC poseen la llamada cache interna de primer nivel o L1; es decir, la que está más cerca del micro, tanto que está encapsulada junto a él. Los micros más modernos (Pentium III Coppermine, athlon Thunderbird, etc.) incluyen también en su interior otro nivel de caché, más grande aunque algo menos rápida, la caché de segundo nivel o L2 e incluso memoria caché de nivel 3, o L3.

- Coprocesador Matemático: o correctamente la FPU (Unidad de coma flotante). Que es la parte del micro especializada en esa clase de cálculos matemáticos, antiguamente estaba en el exterior del procesador en otro chip. Esta parte esta considerada como una parte "lógica" junto con los registros, la unidad de control, memoria y bus de datos.

- Los registros: son básicamente un tipo de memoria pequeña con fines especiales que el micro tiene disponible para algunos usos particulares. Hay varios grupos de registros en cada procesador. Un grupo de registros esta diseñado para control del programador y hay otros que no son diseñados para ser controlados por el procesador pero que CPU los utiliza en algunas operaciones, en total son treinta y dos registros.

- La memoria: es el lugar donde el procesador encuentra las instrucciones de los programas y sus datos. Tanto los datos como las instrucciones están almacenados en memoria, y el procesador las toma de ahí. La memoria es una parte interna de la computadora y su función esencial es proporcionar un espacio de trabajo para el procesador.

- Puertos: es la manera en que el procesador se comunica con el mundo externo. Un puerto es parecido a una línea de teléfono. Cualquier parte de la circuitería de la computadora con la cual el procesador necesita comunicarse, tiene asignado un número de puerto que el procesador utiliza como un número de teléfono para llamar al circuito o a partes especiales.

FABRICANTES

INTEL 80286

El Intel 80286 (llamado oficialmente iAPX 286, también conocido como i286 o 286) es un microprocesador de 16 bits de la familia x86, que fue lanzado al mercado por Intel el 1 de febrero de 1982. Cuenta con 134.000 transistores. Las versiones iniciales del i286 funcionaban a 6 y 8 MHz, pero acabó alcanzando una velocidad de hasta 25 MHz. Fue el microprocesador elegido para equipar al IBM Personal Computer/AT, lo que causó que fuera el más empleado en los compatibles PC (más propiamente compatibles AT) entre mediados y finales de los años 80 .Tras las versiones iniciales a 6 y 8 MHz, Intel lanzó un modelo a 12,5 MHz. AMD y Harris ampliaron esa velocidad a 20 MHz y 25 MHz, respectivamente. En promedio, el 80286 tenía una velocidad de unas 0,21 instrucciones por ciclo de reloj.[1] El modelo de 6 MHz operaba a 0,9 MIPS, el de 10 MHz a 1,5 MIPS, y el de 12 MHz a 2,66 MIPS.[2]

El rendimiento del 80286 es más del doble que el de sus predecesores (los Intel 8086 e Intel 8088) por ciclo de reloj. De hecho, el aumento de rendimiento por ciclo de reloj puede ser el mayor entre las diferentes generaciones de procesadores x86. El cálculo de los modos de direccionamiento más complejos (como base + índice) utilizaban menos ciclos de reloj porque eran realizados por un circuito especial en el 286; el 8086, ha de realizar el cálculo de la dirección efectiva en la ULA general, lo que consume muchos ciclos. Además, operaciones matemáticas complejas (como MUL/DIV) ocupan menos ciclos que en el 8086.

Al tener un bus de direcciones de 24 bits, es capaz de direccionar hasta 16 MB (16 MiB) de memoria RAM, mientras que el 8086 sólo puede 1 MB. Aunque MS-DOS puede utilizar la RAM adicional ( memoria extendida ) mediante una llamada a la BIOS INT 15h, AH=87h), como disco RAM o mediante emulación de memoria expandida previamente habilitada mediante software la memoria extendida, pocos ordenadores basados en el i286 tuvieron más de 1 MB de memoria.

El i286 fue diseñado para ejecutar aplicaciones multitarea, incluyendo comunicaciones (como PBX automatizadas), control de procesos en tiempo real y sistemas multiusuario. Para ello se le añadió un modo protegido, en el cual existían cuatro anillos de ejecución y división de memoria mediante tablas de segmentos. En este modo trabajaban las versiones de 16 bits del sistema operativo OS/2. En este modo protegido se permitía el uso de toda la memoria directamente, y que además ofrecía protección entre aplicaciones para evitar la escritura de datos accidental (o malintencionada) fuera de la zona de memoria asignada. Sin embargo, una vez que el procesador entraba en el modo protegido, no podía volver al modo real sin resetear el procesador. El microcontrolador Intel 8042, utilizado para controlar el teclado en los AT, tiene una función que resetea sólo la CPU (la famosa combinación CTRL - ALT - DEL).

A pesar de su gran popularidad, hoy en día quedan pocos ordenadores con el i286 funcionando.

El sucesor del i286 fue el Intel 80386, de 32 bits.